Big Data (Біг Дата / Великі дані) – це термін, що описує величезні обсяги даних, які зібрані, зберігаються та аналізуються з метою отримання корисної інформації та відкриття нових знань.

Що таке BIG DATA (Біг Дата / Великі дані) — поняття та визначення простими словами.

Простими словами, Big Data, або “великі дані”, – це просто велика кількість інформації, яка збирається з різних джерел і обробляється за допомогою спеціальних інструментів.

Уявіть собі величезну бібліотеку з тисячами книг, де кожна сторінка містить деякі дані. Big Data – це ніби ціла бібліотека, яку ми аналізуємо, щоб знайти важливі знання та відповіді на запитання.

Основні особливості Big Data можна порівняти з трьома “V”: обсяг (Volume), різноманітність (Variety) та швидкість (Velocity). Обсяг — це кількість зібраної інформації, різноманітність — це різні типи даних, а швидкість — це те, наскільки швидко ми можемо збирати та обробляти ці дані.

Big Data використовується у багатьох галузях, таких як медицина, фінанси, маркетинг та інші, для кращого розуміння ситуації, виявлення залежностей та підтримки прийняття рішень. Завдяки Big Data, ми можемо відкривати нові можливості та поліпшувати якість нашого життя.

Першопроходці використання Big Data.

Big Data було вперше застосовано у деяких відомих проектах, які показали потенціал цієї технології та змінили напрямки розвитку різних галузей.

Проект SETI@home: Пошук інтелектуального життя у Всесвіті.

Один з ранніх прикладів використання Big Data — це проект SETI@home, запущений у 1999 році. Його метою було аналізувати величезні обсяги радіосигналів з космосу, щоб виявити можливі сліди інтелектуального життя. В рамках цього проекту дані були розподілені між сотнями тисяч комп’ютерів від приватних користувачів, що стало прототипом сучасних хмарних рішень для обробки Big Data.

Дослідження геному людини: Революція в генетиці.

У 2000-х роках відбулася відома подія в науці — проект розшифровки геному людини. Він вимагав аналізу і зберігання величезної кількості генетичної інформації. Завдяки застосуванню Big Data було створено бази даних генетичних послідовностей, які стали основою для численних наукових досліджень та розвитку персоналізованої медицини.

Компанія Google: Інновації в пошуковій технології.

Google, світовий лідер в галузі пошукових систем, також пішов по шляху використання Big Data з самого свого заснування у 1998 році. Завдяки аналізу величезних обсягів інформації з інтернету, Google зміг вдосконалити свої алгоритми пошуку та створити різноманітні сервіси, такі як Google Maps, Google Analytics та Google Ads, які революціонізували світ цифрового маркетингу, реклами та аналітики.

Netflix: Персоналізація рекомендацій у стрімінгових сервісах.

Стрімінговий відеосервіс Netflix став ще одним піонером застосування Big Data. Вони почали аналізувати великі обсяги даних про своїх користувачів та їхні переглядові звички ще у 2000-х роках. Застосування алгоритмів машинного навчання дозволило Netflix створювати персоналізовані рекомендації для кожного користувача, підвищуючи задоволеність від послуг та забезпечуючи лояльність аудиторії.

Ці та інші ранні випадки використання Big Data надихнули інші компанії та організації досліджувати можливості даної технології. З часом Big Data стало ключовим інструментом для аналізу даних у багатьох галузях, від охорони здоров’я до фінансів, і продовжує відкривати нові горизонти в розвитку сучасного світу.

Зародження та популярність терміна Big Data.

Щоб зрозуміти, як з’явилась назва “Big Data” та як вона набула популярності у технологічному світі, давайте зануримося в історію цього поняття.

- Походження терміна Big Data. Термін “Big Data” з’явився наприкінці 1990-х років, проте деякі джерела стверджують, що він виник ще у 1970-х. Першим, хто вжив цей термін, був Джон Масгей, експерт у галузі комп’ютерних наук, який назвав “великі дані” одним з головних викликів сучасної інформатики.

- Набуття популярності терміна. На початку 2000-х, з розвитком інтернету та початковим впровадженням Big Data технологій, термін став все більш відомим у технічному середовищі. У 2011 році відбулась важлива подія — визначний аналітичний центр Gartner визнав Big Data одною з ключових стратегічних технологій, що сприяло зростанню інтересу до даної теми.

- Big Data набирає обертів. З початком 2010-х, коли багато компаній почали впроваджувати Big Data у своїх процесах, відбулась революція у використанні цих технологій. Науковці, аналітики та бізнес-професіонали зрозуміли значення Big Data для розвитку інновацій, забезпечення конкурентоспроможності та створення нових можливостей.

Таким чином, термін “Big Data” поступово став синонімом успішності, аналітичних здібностей та стратегічного розвитку у сучасному технологічному світі.

Ключові особливості Big Data.

Для кращого розуміння суті Big Data, розглянемо п’ять основних характеристик, які відрізняють великі дані від традиційної обробки інформації:

- Обсяг. Однією з найбільш очевидних рис Big Data є великий обсяг даних, який постійно зростає. Це стосується терабайт, петабайт, ексабайт і навіть зетабайт інформації, яка щодня генерується різними джерелами, включаючи інтернет, соціальні мережі, датчики, мобільні пристрої тощо.

- Різноманітність. Big Data включає в себе різні типи даних: структуровані, напівструктуровані та неструктуровані. Це можуть бути числа, текст, зображення, аудіо- та відеофайли, геолокаційні дані тощо. Обробка такої великої різноманітності даних потребує особливих методів та інструментів.

- Швидкість. Швидкість, з якою збираються, обробляються та аналізуються дані, також відіграє важливу роль в Big Data. Високі темпи обробки даних дозволяють компаніям реагувати на зміни в реальному часі та приймати відповідні рішення швидше.

- Достовірність. Важливою характеристикою Big Data є достовірність даних, яка відображає точність, консистентність та актуальність інформації. Неправильна, неконсистентна або застаріла інформація може призвести до помилкових висновків та стратегічних рішень.

- Цінність. Кінцевою метою аналізу великих даних є виявлення цінної інформації, яка може допомогти компаніям оптимізувати свої процеси, забезпечити конкурентні переваги та прискорити інноваційний розвиток. Цінність Big Data полягає в здатності виявляти зв’язки, тенденції та шаблони, які були раніше приховані або непомітні.

Вплив характеристик Big Data на різні галузі.

Враховуючи вищеописані характеристики, можна зрозуміти, чому Big Data стала ключовою технологією у багатьох галузях. Обсяг, різноманітність, швидкість, достовірність та цінність даних впливають на підхід до аналізу інформації, що відкриває нові можливості для підприємств.

Приклади впливу Біг Дата на різні галузі:

- У маркетингу і рекламі: Big Data допомагає компаніям краще розуміти потреби своїх клієнтів, розробляти ефективніше комунікаційні стратегії та відстежувати результати рекламних кампаній.

- У фінансовій сфері: великі дані використовуються для виявлення шахрайства, кредитного ризику, а також для вдосконалення алгоритмічної торгівлі.

- У здоров’ї: аналіз великих даних може допомогти у виявленні епідемій та пандемій, покращенні пацієнтського досвіду та прискоренні розвитку нових ліків і терапій.

- У науці: Big Data відіграє важливу роль у великомасштабних наукових дослідженнях, як-от астрономія, геноміка, кліматологія тощо.

Враховуючи широкий вплив Big Data на різні галузі, можна сказати, що технологія стала важливим інструментом для компаній, організацій та наукових установ у сучасному світі. Завдяки аналізу великих даних, зацікавлені сторони можуть забезпечити більш ефективне прийняття рішень, відкрити нові можливості та відстежувати свій прогрес у реальному часі.

Щоб забезпечити успіх у використанні Big Data, необхідно мати не тільки спеціалістів, які розуміють ці характеристики, але й потрібні технічні ресурси, такі як аналітичне програмне забезпечення, потужні комп’ютери та відповідні алгоритми для обробки великого обсягу різноманітних даних.

Висновок: ключові особливості Big Data, такі як обсяг, різноманітність, швидкість, достовірність та цінність, значно впливають на різні галузі сучасного світу. Впровадження Big Data у різних секторах може забезпечити ряд переваг, включаючи підвищення ефективності, відкриття нових можливостей та забезпечення конкурентних переваг. Для досягнення оптимальних результатів, важливо розуміти особливості великих даних та мати належні технічні ресурси та кваліфікованих спеціалістів.

Внутрішній механізм Big Data: Збір, обробка та аналіз великих даних.

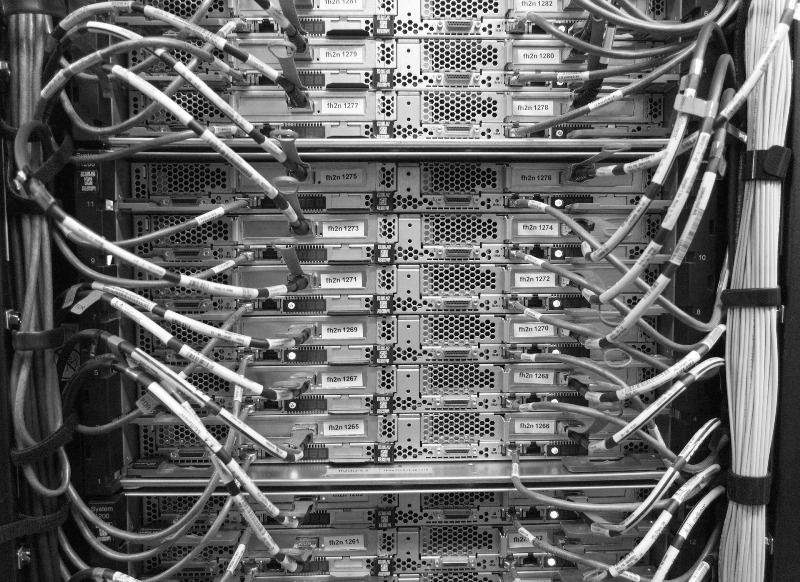

Важливим аспектом Big Data є процеси збору, обробки та аналізу даних. Збір даних відбувається з різних джерел, як-от соціальні медіа, IoT-пристрої, датчики та багато інших. Після збору, дані потрібно опрацювати, щоб відфільтрувати, очистити та структурувати їх для подальшого аналізу.

Роль зберігання даних, систем обробки та аналітичних інструментів.

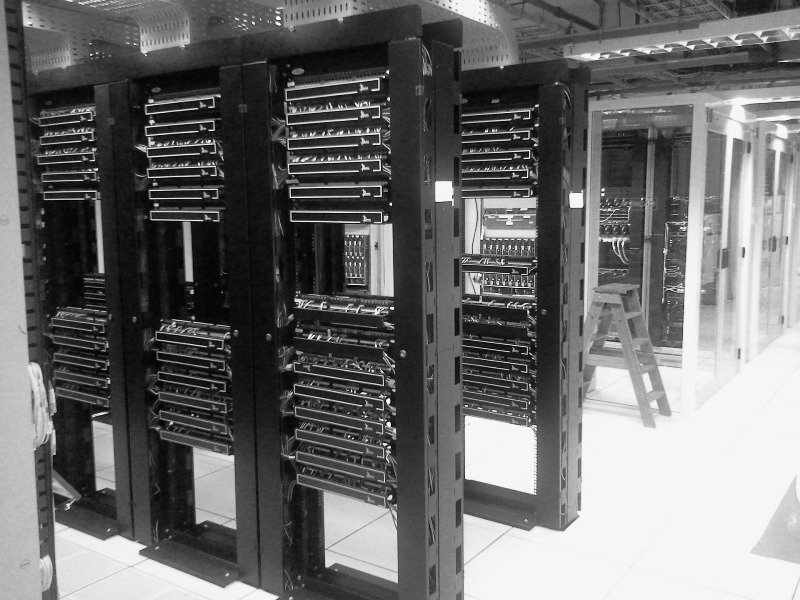

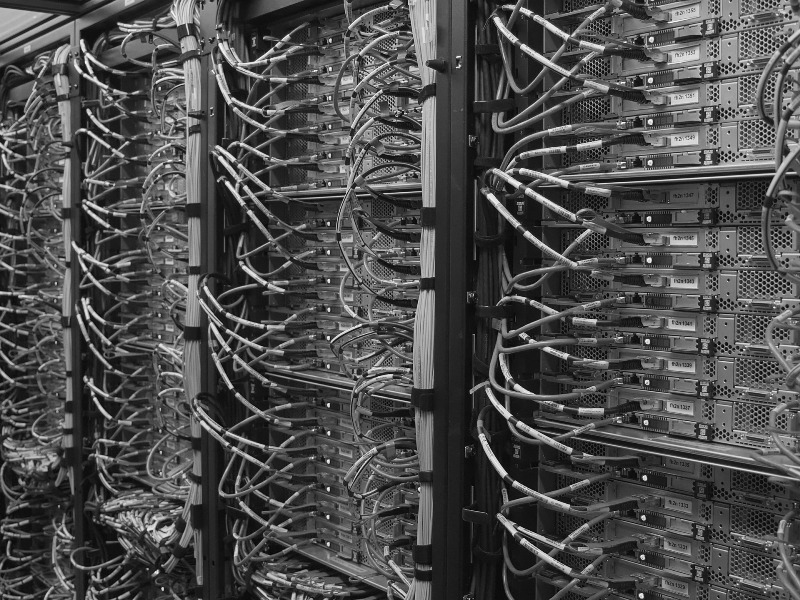

Для зберігання та обробки великих даних використовуються спеціальні системи зберігання даних та обробки інформації, такі як Hadoop, Spark, NoSQL бази даних та інші. Ці технології дозволяють зберігати та обробляти великі обсяги різноманітних даних швидко та ефективно.

Щодо аналітичних інструментів, існує безліч програмних рішень, які допомагають компаніям вивчати тенденції, виявляти закономірності та отримувати цінні висновки з великих даних. Вони включають інструменти для обробки тексту, візуалізації даних та машинного навчання.

Важливість конфіденційності та безпеки даних.

З огляду на обсяг та чутливість інформації, яка обробляється в Big Data, велику увагу приділяють питанням конфіденційності та безпеки даних. Забезпечення захисту даних користувачів та дотримання законодавства щодо обробки персональних даних є критично важливим для будь-якої організації, яка працює з великими даними. Це включає застосування різних методів шифрування, аутентифікації, авторизації та аудиту.

Інтеграція даних та забезпечення якості даних.

Ще одним важливим аспектом роботи з великими даними є інтеграція та забезпечення якості даних. Інтеграція даних полягає в об’єднанні різних джерел даних у єдину систему, яка може бути легко оброблена та аналізована. Забезпечення якості даних включає відфільтровування неточностей, дублікатів та пропущених значень, що допомагає підвищити точність аналізу та прийняття рішень на основі великих даних.

Майбутнє Big Data та його вплив на суспільство.

Big Data продовжує розвиватися, а з ним зростає і його вплив на різні аспекти суспільства. Від галузі охорони здоров’я до фінансів, від освіти до урядових організацій, застосування великих даних відкривають нові можливості для відкриття знань та поліпшення життя людей.

Очікується, що в майбутньому використання великих даних стане ще більш поширеним та інтегрованим у повсякденне життя людей. Це може призвести до створення нових продуктів та послуг, які будуть базуватися на індивідуальних потребах та перевагах користувачів, а також до зміцнення безпеки та прозорості використання даних.

Основні технології Big Data та їх екосистема: Hadoop, Spark та NoSQL бази даних.

Big Data використовує різноманітні технології для ефективного зберігання, обробки та аналізу великих обсягів інформації. Деякі з найпопулярніших технологій, які використовуються в цій сфері, включають Hadoop, Spark та NoSQL бази даних. Розглянемо роль та функціональність цих технологій у процесі обробки великих даних.

Hadoop: розподілена обробка великих даних.

Hadoop – це відкрите програмне забезпечення, яке дозволяє зберігати та обробляти великі набори даних на кластерах з дешевих серверів. Він базується на моделі розподіленого файлового системи Hadoop Distributed File System (HDFS), який дозволяє розподілити обсяги даних між вузлами кластера. Основними компонентами Hadoop є HDFS та MapReduce, який відповідає за паралельну обробку даних на різних вузлах кластера.

Spark: швидкісна обробка та аналіз даних.

Spark – це інший відкритий проект для обробки великих даних, який розроблений для швидкісної обробки та аналізу даних у реальному часі. Він використовує власний кластерний менеджер, а також може працювати з Hadoop або Mesos. Spark надає інтерфейси для різних мов програмування, таких як Scala, Java та Python, і містить бібліотеки для машинного навчання, графічного аналізу та обробки потокових даних.

NoSQL бази даних: гнучкість та масштабованість.

NoSQL бази даних — це група баз даних, які відрізняються від традиційних реляційних баз даних за свою гнучкість та масштабованість. Вони дозволяють зберігати та обробляти неструктуровані та напівструктуровані дані, які є поширеними в Big Data. NoSQL бази даних можуть мати різні типи, зокрема ключ-значення, колонкові, документні та графові бази даних. Відомі приклади NoSQL баз даних включають Cassandra, MongoDB та Couchbase.

Взаємодія та інтеграція технологій Big Data.

Важливо зазначити, що ці технології часто взаємодіють та інтегруються для створення комплексних рішень Big Data. Наприклад, Hadoop та Spark можуть працювати разом для обробки та аналізу великих даних, використовуючи HDFS як основу для зберігання даних. NoSQL бази даних можуть бути використані для зберігання та обробки неструктурованих даних, які потім можуть бути аналізовані за допомогою Spark або Hadoop.

Екосистема Big Data.

Екосистема Big Data складається з різних компонентів, які працюють разом, щоб забезпечити ефективне зберігання, обробку та аналіз великих даних. Це включає не лише вищезгадані технології, але й інші інструменти та рішення, такі як ETL-інструменти (Extract, Transform, Load), системи управління даними, аналітичні платформи, інфраструктура та сервіси хмарного обчислення.

Загалом, Hadoop, Spark та NoSQL бази даних є ключовими технологіями, які допомагають організаціям ефективно зберігати та обробляти великі даних. Розуміння їх ролей та функціональності допоможе професіоналам в галузі інформаційних технологій краще використовувати потенціал великих даних та розробляти ефективні рішення для аналізу та обробки інформації.

Адаптація та вибір правильних технологій Big Data.

Оскільки кожна організація має свої власні потреби та вимоги щодо обробки великих даних, важливо адаптувати технології та інструменти до конкретних ситуацій. Вибір правильної комбінації технологій Big Data залежить від ряду факторів, таких як обсяг даних, типи даних, необхідна швидкість обробки, доступність ресурсів та бюджет.

Для успішної реалізації проектів з використанням великих даних, спеціалісти повинні ретельно проаналізувати свої потреби, врахувати обмеження та можливості різних технологій, а також слідкувати за новими розвитками та тенденціями в сфері Big Data.

Навчання та розвиток компетенцій у сфері Біг Дата.

Оскільки технології великих даних постійно розвиваються, для фахівців у галузі IT важливо постійно вдосконалювати свої навички та знання. Існують різні курси, сертифікаційні програми та інші ресурси, які можуть допомогти спеціалістам ознайомитися з основами технологій Big Data, розробляти нові рішення та підтримувати свої компетенції на високому рівні.

Приклади використання Big Data у реальному світі.

Використання великих даних впливає на різні сектори економіки, від здоров’я та фінансів до маркетингу. Розглянемо конкретні приклади застосування Big Data у різних галузях та дізнаємося про переваги та виклики, пов’язані з використанням великих даних.

- Здоров’я: Персоналізація медичного обслуговування. У сфері охорони здоров’я, використання великих даних дозволяє збирати та аналізувати відомості про пацієнтів, такі як генетичні дані, дані про стан здоров’я та медичні записи, для розробки персоналізованих планів лікування. Це може допомогти у підвищенні ефективності медичних послуг, зменшенні витрат та поліпшенні якості догляду за пацієнтами.

- Фінанси: Краще управління ризиками та виявлення шахрайства. У фінансовій сфері, аналіз великих даних допомагає організаціям краще управляти ризиками та виявляти шахрайство. За допомогою аналізу транзакцій, кредитних рейтингів та інших даних, фінансові установи можуть розробляти моделі ризику, що допоможуть їм приймати обґрунтовані рішення про кредитування та інвестиції.

- Маркетинг: Цілеспрямована реклама та аналіз споживчої поведінки. У маркетингу, використання великих даних дозволяє компаніям краще зрозуміти споживчий попит та ринкові тенденції. За допомогою аналізу інформації про покупців, їхніх відгуків та поведінку у соціальних мережах, компанії можуть розробляти цілеспрямовані рекламні кампанії та пропозиції, які краще відповідають потребам споживачів. Також аналіз великих даних допомагає виявляти нові ринкові ніші та можливості для розвитку бізнесу.

Переваги та виклики використання Big Data.

Використання великих даних пропонує ряд переваг для різних секторів економіки. Деякі з них включають:

- Підвищення ефективності рішень: Big Data дозволяє проводити глибокий аналіз даних, що сприяє прийняттю кращих рішень та оптимізації бізнес-процесів.

- Більш точне прогнозування: Застосування аналітичних моделей на великих даних може допомогти у прогнозуванні тенденцій ринку, попиту на продукцію та потреб споживачів.

- Інноваційний розвиток: Великі дані стимулюють інновації, допомагаючи організаціям відкривати нові можливості та стратегії розвитку.

Однак, разом з перевагами, використання великих даних також має свої виклики:

- Забезпечення конфіденційності та безпеки даних: Організації повинні бути особливо обережні щодо збереження та обробки великих обсягів даних, щоб уникнути порушень конфіденційності та втрати даних.

- Витрати на інфраструктуру та обробку даних: Зберігання та обробка великих даних може бути вартісною справою, що вимагає значних інвестицій у обладнання та програмне забезпечення, а також відповідного рівня експертизи працівників.

- Обробка неструктурованих даних: Багато великих даних надходять у неструктурованому вигляді, наприклад, текстові повідомлення, зображення та відео. Організаціям необхідно розробляти нові методи та алгоритми для ефективної обробки та аналізу таких даних.

- Етичні питання: Використання великих даних може порушувати приватність користувачів та збільшувати ризики щодо їхньої конфіденційності. Організаціям потрібно враховувати етичні аспекти при зборі, обробці та використанні великих даних.

Використання великих даних може принести значні переваги для різних галузей економіки, таких як охорона здоров’я, фінанси та маркетинг. Однак, успішне застосування великих даних вимагає розуміння відповідних технологій, здатності розробляти ефективні рішення для аналізу та обробки даних, а також врахування викликів, пов’язаних з конфіденційністю, безпекою та етикою.

Готуємося до майбутнього: Нові тенденції та інновації в технології великих даних.

Відбуваються значні зміни та розвиток в галузі великих даних, зокрема з’явлення нових алгоритмів машинного навчання, штучного інтелекту та хмарних рішень для зберігання даних. Ці інновації відкривають нові можливості для більш ефективної обробки та аналізу великих даних, що дає компаніям можливість отримувати нові стратегічні переваги.

Важливість розвитку культури, заснованої на даних, в організаціях.

Забезпечення успіху в епоху великих даних вимагає від організацій створення культури, яка підтримує та розвиває використання даних для прийняття рішень на всіх рівнях. Це включає навчання та освіту співробітників, забезпечення доступу до необхідних інструментів та ресурсів для аналізу даних, а також створення прозорих процесів для обміну знаннями та найкращими практиками.

Організаціям варто активно інтегрувати великі дані в свою стратегію та планування, щоб оптимізувати робочі процеси, підвищити ефективність та покращити результати. Відстеження нових тенденцій, розвиток компетенцій та взаємодія з іншими підприємствами, які також використовують великі дані, допоможуть організаціям залишатися на передовій цієї революційної технології та забезпечити успіх у майбутньому.

Взаємозв’язок: Big Data, Штучний інтелект, Нейромережі та Блокчейн.

- Big Data та штучний інтелект. Великі дані і штучний інтелект (AI) тісно пов’язані між собою, оскільки AI використовує великі дані для навчання та виявлення закономірностей. Завдяки великим обсягам даних, AI може вчитися та розвиватися, стаючи дедалі потужнішим у передбаченні та аналізі. Відповідно, використання AI стає все більш поширеним у різних галузях, включаючи медицину, фінанси та маркетинг.

- Big Data та нейромережі. Нейромережі – це тип алгоритмів машинного навчання, які намагаються імітувати роботу людського мозку для вирішення складних проблем. Використовуючи великі дані, нейромережі можуть навчатися ідентифікувати шаблони та робити висновки, навіть якщо дані містять шум або неповні інформації. Особливо нейромережі корисні у таких галузях, як комп’ютерний зір, природна обробка мови та рекомендаційні системи.

- Big Data та блокчейн. Блокчейн – це децентралізована технологія обліку, яка забезпечує високий рівень безпеки, прозорості та незалежності від одного контролюючого органу. Завдяки можливостям блокчейну, він може використовуватися для зберігання та обробки великих даних, забезпечуючи надійність та анонімність інформації. Це відкриває нові можливості в ряді галузей, наприклад, фінансів, логістики, охорони здоров’я та ін.

Висновок.

Розуміння великих даних є надзвичайно важливим у сучасному світі, оскільки вони грають ключову роль у вирішенні найактуальніших проблем і створенні нових можливостей. Впровадження великих даних в різних сферах, таких як охорона здоров’я, фінанси, маркетинг та багато інших, дозволяє покращувати продуктивність, ефективність та інноваційність.

Водночас зростає значення знань та навичок, пов’язаних з великими даними, оскільки спеціалісти у цій сфері стають все більш вимогливими на ринку праці. Оволодіння технологіями обробки великих даних, такими як Hadoop, Spark та NoSQL, дає фахівцям змогу забезпечити високу конкурентоспроможність своїм організаціям.

Також важливо відзначити взаємозв’язок великих даних з іншими передовими технологіями, такими як штучний інтелект, нейромережі та блокчейн. Спільне використання цих технологій може відкрити нові горизонти для розвитку суспільства і допомогти вирішити проблеми, які раніше вважалися нерозв’язними.

FAQ (Поширені питання):

Big Data означає великі обсяги даних, які збираються, зберігаються та аналізуються з метою отримання корисної інформації. Ці дані можуть бути структурованими, напівструктурованими або неструктурованими.

Прикладами Big Data можуть бути дані соціальних мереж, лог-файли серверів, дані з сенсорів Інтернету речей (IoT), метеорологічні дані та багато іншого.

Термін “Big Data” з’явився офіційно у 2001 році, коли Мета Груп (тепер Gartner) опублікувала доповідь, в якій аналізувала зростання обсягів даних та їх вплив на бізнес-процеси.

Основні характеристики Big Data включають обсяг (Volume), швидкість (Velocity), різноманітність (Variety), достовірність (Veracity) та цінність (Value).

Великі обсяги даних, що збираються, зазвичай називаються “Big Data” або великими даними.

Для обробки великих даних використовуються різноманітні технології, такі як Hadoop, Spark, NoSQL бази даних, алгоритми машинного навчання та штучного інтелекту.